Digitale Manipulation – Eine Gefahr für die Gesellschaft

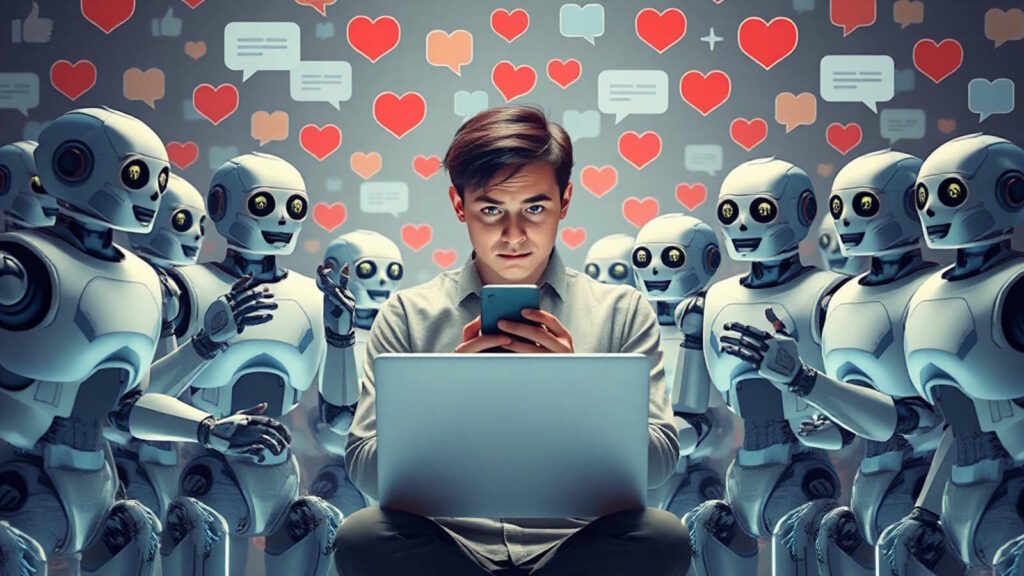

Soziale Netzwerke sind aus dem Alltag nicht mehr wegzudenken. Sie haben die Art und Weise, wie Kommunikation, Wissensaustausch und politische Debatten stattfinden, grundlegend verändert. Gleichzeitig sind sie zunehmend Schauplatz von gezielter Manipulation, Einflussnahme und Desinformation. Die Tragweite dieser Entwicklung reicht von der individuellen Meinungsbildung bis hin zur Beeinflussung gesellschaftlicher und politischer Prozesse. Manipulation findet in sozialen Netzwerken subtil, aber effektiv statt: Durch Algorithmen, Fake-Profile, Social Bots und gezielte Kampagnen. Wer ihre Mechanismen versteht, erkennt die Methoden der Täuschung und kann sich besser davor schützen.

Was bedeutet Manipulation in sozialen Netzwerken?

Manipulation in sozialen Netzwerken beschreibt alle bewussten Versuche, die Wahrnehmung, das Denken, die Gefühle oder das Verhalten von Nutzerinnen und Nutzern zum eigenen Vorteil zu beeinflussen. Das Spektrum reicht von sanften Beeinflussungen über gezielte Desinformation bis hin zu umfassenden psychologischen Strategien.

Synonyme & verwandte Begriffe bezüglich Manipulation

- Beeinflussung

- Täuschung

- Meinungskontrolle

- Lenkung

- Propaganda

- psychologische Steuerung

Typische Formen von Manipulation

- Verbreitung gezielter Falschinformationen (Desinformation)

- Shitstorms und künstliche Empörungswellen

- Trendsetzung durch Hashtag-Kampagnen

- Microtargeting und gezielte Werbeanzeigen

- Aufbau von Echokammern und Filterblasen

Wie funktioniert Manipulation in sozialen Netzwerken?

Digitale Manipulation beruht auf einer Mischung aus psychologischen Methoden und technologischen Möglichkeiten. Entscheidende Werkzeuge sind dabei Social Bots, Algorithmen, gezielte Werbeanzeigen und z. T. ausgefeilte Kommunikationsstrategien.

2.1 Die Rolle der Algorithmen

Algorithmen sortieren und gewichten Inhalte, die im Feed angezeigt werden. Nutzer erhalten damit vorrangig die Inhalte, die zu ihrem bisherigen Verhalten passen und sie emotional ansprechen. Dadurch werden extreme Standpunkte und emotionalisierte Botschaften besonders verstärkt.

Wirkungsmechanismen:

- Hervorheben polarisierender Inhalte

- Verstärkung von Gruppendenken (“Echokammern”)

- Förderung der Verbreitung von Clickbait und Sensationsmeldungen

2.2 Social Bots und Fake-Profile

Social Bots sind automatisierte Programme, die als echte Nutzer getarnt agieren. Sie setzen gezielt Kommentare ab, verbreiten Inhalte und verstärken bestimmte Trends.

Funktionen von Social Bots:

- Verbreitung und Verstärkung von Hashtags und Trends

- Erzeugung künstlicher Zustimmung (“Like-Farmen”)

- Automatisches Teilen von Falschinformationen

| Merkmale von Social Bots | Typische Aktivitäten |

|---|---|

| Keine echten Profilangaben | Massives Kommentieren/Retweeten |

| Unnatürliches Posting-Verhalten | Schnelles Teilen vieler Inhalte |

| Kaum individuelle Posts | Oft politische oder polarisierende Themen |

Microtargeting und personalisierte Werbung

Gezielte Einflussnahme nutzt detaillierte Datenprofile und spielt Einzelpersonen maßgeschneiderte Anzeigen oder Inhalte aus. Dadurch wird die Wirkung von manipulativen Botschaften maximiert.

Beispiele für Microtargeting:

- Politische Kampagnen, die bestimmten Nutzergruppen spezielle Themen zuspielen

- Werbung, die persönliche Unsicherheiten oder Vorlieben anspricht

- Desinformation, die gezielt auf bestimmte Meinungen oder Ängste zugeschnitten ist

Typen gezielter Manipulation: Von Fake News bis Social Engineering

Verbreitung von Fake Nachrichten

Fake Nachrichten sind absichtlich erfundene oder manipulierte Nachrichten, die Menschen täuschen und beeinflussen sollen. Sie werden über soziale Netzwerke rasant verbreitet.

Typische Beispiele:

- Überspitzte oder gänzlich erfundene politische Meldungen

- Gefälschte Bilder oder Videos

- Irreführende “Breaking News” in Krisenzeiten

Astroturfing und künstliche Kampagnen

Astroturfing ist die künstliche Erzeugung von vermeintlich spontanen Graswurzelbewegungen (englisch grassroots movement), z. B. durch gekaufte Likes, gefälschte Kommentare oder inszenierte Bewertungen.

Ziele von Astroturfing:

- Erwecken von öffentlicher Unterstützung

- Druck auf Unternehmen, Politiker oder Prominente ausüben

- Meinungen manipulieren, als kämen sie aus der breiten Bevölkerung

| Beispiel für Astroturfing | Erkennungsmerkmale |

|---|---|

| Plötzliches Auftauchen vieler gleichlautender Kommentare | Identische oder sehr ähnliche Formulierungen, viele anonyme Profile |

| Ungewöhnliche Zunahme von Likes | Meist keine „echte“ Interaktion abseits der Kampagne |

Social Engineering

Social Engineering bezeichnet psychologische Methoden, um digitale Manipulation bei Individuen herbeizuführen – etwa durch das gezielte Schüren von Angst, Unsicherheit oder Gruppenzwang. Social Engineering nutzt gezielt menschliche Schwächen und kognitive Verzerrungen aus, um Menschen im digitalen Raum zu beeinflussen oder zu manipulieren. Typisch ist dabei, dass der Angreifer nicht auf technische Sicherheitslücken zielt, sondern direkt auf Verhalten, Emotionen und Routinen.

Oft versucht Social Engineering, durch das Erzeugen von Stress oder Zeitdruck eine schnelle, unüberlegte Reaktion hervorzurufen. Das kann beispielsweise darin bestehen, dass vermeintlich wichtige Nachrichten, Warnungen oder Bitten um Hilfe mit emotionalen Auslösern versehen werden: Bedrohungsszenarien (“Ihr Konto wird gesperrt!”), angebliche Dringlichkeit (“Nur noch wenige Minuten!”) oder das Vortäuschen sozialer Nähe (“Ein Freund braucht Hilfe!”) sind häufig eingesetzte Methoden.

Eine weitere Strategie ist der Aufbau von Gruppendruck – etwa, indem behauptet wird, “alle anderen” hätten bereits eine bestimmte Aktion ausgeführt (“Schon 90 % der Nutzer haben abgestimmt!”) oder sich einer Bewegung angeschlossen. Social Engineering kann so jemanden dazu bringen, persönliche Daten preiszugeben, auf vermeintliche Spendenaufrufe zu reagieren, schädliche Inhalte zu teilen oder Passwörter weiterzugeben. Gerade in sozialen Netzwerken sind diese Ansätze besonders wirksam, weil Informationen schnell und scheinbar glaubhaft von Kontakt zu Kontakt wandern. Die Gefahr besteht darin, dass Nutzer emotionale Reaktionen häufig über rationales Nachdenken stellen – und so zu Opfern digitaler Manipulation werden.

Beispiele für Social Engineering in sozialen Netzwerken

- Kettenbriefe mit manipulativer Botschaft

- Falsche Hilferufe (“Teile dies, damit XY gefunden wird!”)

- Emotional aufgeladene Inhalte, um zu sofortigen Reaktionen zu bewegen (“Wenn du dagegen bist, like jetzt!”)

Ziele und Auswirkungen gezielter Manipulation

Die Motive und Ziele hinter gezielter Manipulation in sozialen Netzwerken sind vielfältig. Sie reichen von politischer oder wirtschaftlicher Machtgewinnung bis zur Störung gesellschaftlicher Strukturen.

Politische Einflussnahme und Wahlmanipulation

Manipulationstechniken werden gezielt eingesetzt, um Meinungen im Vorfeld von Wahlen oder politischen Abstimmungen zu beeinflussen. Dabei spielen Social Bots, Fake News und gezieltes Microtargeting eine entscheidende Rolle.

Beispielhafte politische Ziele:

- Schwächung von Kandidaten oder Parteien durch negative Kampagnen

- Förderung von Wahlverdrossenheit oder gezieltem Desinteresse

- Unterstützung extremistischer Positionen

Wirtschaftliche Interessen

Auch Unternehmen nutzen die Macht der Manipulation in sozialen Netzwerken, etwa durch gezieltes Influencer-Marketing, gekaufte Bewertungen oder getarnte Werbung.

Wirtschaftliche Manipulationsformen:

- Positive Rezensionen für eigene Produkte, negative für Konkurrenz

- Influencer, die gezielt bezahlte Inhalte unkenntlich platzieren

- Virale Kampagnen zur Verbreitung von Trends und Hypes

Polarisierung und gesellschaftliche Spaltung

Durch die gezielte Verbreitung kontroverser oder falscher Inhalte werden Spaltungen in der Gesellschaft verstärkt. Echokammern (Filter Bubbles) animieren Nutzer dazu, kritische Informationen auszublenden und die eigene Meinung für einzig gültig zu halten.

| Auswirkungen gezielter Manipulation | Beispiel/Erklärung |

|---|---|

| Zunahme von Hassrede und Extremen | Shitstorms, Hatespeech |

| Vertrauensverlust in Medien/Politik | Zweifel an offiziellen Informationen |

| Geringere Dialogbereitschaft | Gegenseitiges Ausblenden anderer Meinung |

Methoden der Manipulation – Werkzeuge und Mechanismen im Detail

Bilder- und Videomanipulation

Moderne Bildbearbeitungssoftware, Deepfakes und KI-Tools machen es einfach, Bilder und Videos zu fälschen. Diese werden dazu genutzt, bestimmte Narrative zu unterstützen oder Fakten scheinbar visuell zu “beweisen”.

Typische Anwendungsbeispiele:

- Gefälschte Zitate in Memes

- Ausschnitte aus Videos, die aus dem Kontext gerissen werden

- “Beweisfotos”, die digital verfälscht sind

Hashtag-Kampagnen und Trending Topics

Durch koordinierte Hashtag-Kampagnen manipulieren Akteure, welche Themen in den sozialen Netzwerken sichtbar und relevant erscheinen.

Beispiele für manipulative Hashtags:

- Politische Slogans, die massenhaft verbreitet werden

- Bewegungen, die eigentlich nur von wenigen Nutzern ausgehen

- Kommerzielle Trends, die viral “inszeniert” werden

Emotionalisierung und Clickbait

Manipulation funktioniert besonders dann, wenn sie an Emotionen appelliert. Überspitzte Überschriften, Skandaleffekte und Geschichten, die Nutzer wütend oder ängstlich machen, werden deshalb bevorzugt eingesetzt.

Typische Taktiken:

- Übertreibung und Dramatisierung

- Skandalisierung von Alltagsthemen

- Einsatz von “Schockbildern” oder schockierenden Vergleichen

Manipulation erkennen: Warnsignale und Selbstschutz

Warnsignale gezielter Manipulation

| Warnsignal | Beschreibung |

|---|---|

| Plötzlich viele identische Kommentare | Häufig Zeichen koordinierter Kampagnen oder Bot-Einsatz |

| Anonyme oder neue Profile | Gefälschte Identitäten dienen oft der Meinungsbeeinflussung |

| Übermäßige Emotionalisierung | Beiträge wollen gezielt provozieren oder aufstacheln |

| Fehlende oder zweifelhafte Quellen | Kontrollierbarkeit und Seriosität fehlen |

| Starke Vereinfachungen | “Schwarz-Weiß-Denken” ohne Grauzonen |

| Extrem viele Teilungen in kurzer Zeit | Unnatürliche Viralität, oft durch Bots erzeugt |

| Inhalt wird zu extremer Handlung aufgefordert | “Jetzt teilen!”, “Unbedingt lesen!”, “Widerspreche sofort!” |

Checkliste zur Erkennung von Manipulation

- Quellen sorgfältig prüfen (Wer veröffentlicht das? Gibt es unabhängige Bestätigungen?)

- Profil der Urheber ansehen (Anonym? Erst seit Kurzem aktiv?)

- Emotionalisierende Sprache und reißerische Überschriften vorsichtig betrachten

- Bild- und Videoinhalte mit Reverse Search Tools überprüfen

- Auf Muster bei Kommentaren achten (Viele gleiche oder ähnliche Beiträge?)

Schutzmaßnahmen gegen gezielte Manipulation

Individuelle Schutzstrategien

Eigene Medienkompetenz stärken:

- Kritisch hinterfragen, bevor geteilt, kommentiert oder geliked wird

- Mehrere Quellen vergleichen

- Faktenchecks zu aktuellen Themen nutzen (Correctiv, Mimikama, Faktenfinder etc.)

Technische Möglichkeiten

Tools und Einstellungen:

- Privatsphäre-Einstellungen in sozialen Netzwerken aktivieren

- Werbe- und Tracking-Blocker nutzen

- Benachrichtigungseinstellungen reduzieren, um Algorithmen weniger Einfluss zu geben

- Inhalte melden, wenn sie offensichtlich manipulativ oder falsch sind

Gesellschaftliche und politische Ansätze

- Förderung der Medienbildung in Schulen und Erwachsenenbildung

- Regulierung von Social Bots und klarere Kennzeichnung automatisierter Inhalte

- Stärkere Transparenzvorgaben für Social-Media-Plattformen und Werbeanzeigen

Die Rolle von Plattformen und Regulierern

Verantwortung der Netzwerke

Soziale Netzwerke wie Facebook, X/Twitter, Instagram und TikTok stehen in der Verantwortung, Missbrauch zu erkennen und einzudämmen.

Wünschenswerte Maßnahmen der Anbieter (bisher nicht oder kaum angewandt):

- Kennzeichnung von Fake-Accounts und Bots

- Löschung und Markierung von Falschmeldungen

- Kooperation mit Faktencheck-Organisationen

- Transparenzberichte zu Desinformations-Kampagnen

Gesetzliche Regelungen

Viele Länder verschärfen inzwischen ihre Gesetze, um Manipulation und Desinformation im Netz einzudämmen. Beispiele sind das NetzDG (Deutschland), der Digital Services Act (EU) oder spezielle Vorschriften gegen Wahlmanipulation.

Entwicklungen und Trends: Wie verändert sich Manipulation in sozialen Netzwerken?

Künstliche Intelligenz und Deepfakes

KI-gestützte Systeme werden immer leistungsfähiger – von der Generierung realistisch wirkender Texte, Bilder und Videos bis hin zur Steuerung kompletter Kampagnen. Deepfakes machen es immer komplizierter, Fälschungen auf den ersten Blick zu entlarven.

Neue soziale Plattformen

Mit dem Aufkommen neuer sozialer Medien wandeln sich auch die Methoden der Einflussnahme, z.B. durch die Integration von Live-Video, Stories und privaten Gruppen. Insbesondere verschieben sich Kommunikationswege zunehmend in geschlossene oder schwer einsehbare Bereiche wie Messenger-Dienste oder private Gruppen. Dadurch wird es für Beobachter, Journalisten und sogar Plattformbetreiber schwieriger, Manipulation und Desinformation rechtzeitig zu erkennen und ihnen entgegenzutreten.

Zudem entstehen mit innovativen Funktionen wie automatisierten Kurzvideos, viralen Challenges oder exklusiven Community-Bereichen neue Möglichkeiten, Meinungen subtil zu beeinflussen. Die ständige Weiterentwicklung der Plattformen treibt auch die Professionalisierung von manipulativen Akteuren voran, die immer schneller auf Trends reagieren und ihre Strategien anpassen.

Internationale Dimension

Manipulation findet immer seltener nur auf nationaler Ebene statt: Akteure und Kampagnen sind global vernetzt und greifen direkt in internationale Diskurse ein. In sozialen Netzwerken verschwimmen geografische und sprachliche Grenzen fast vollständig – Inhalte können blitzschnell weltweit gestreut werden. Internationale Gruppen koordinieren ihre Strategien und nutzen globale Reichweiten, um politische, wirtschaftliche oder gesellschaftliche Debatten gezielt zu beeinflussen.

Dabei werden zentrale Themen wie Migration, Klimawandel oder Wahlen häufig auch in anderen Ländern instrumentalisiert, um Unsicherheit zu schüren oder gesellschaftliche Spannungen zu verschärfen. So entsteht eine neue Dimension der Manipulation, bei der globale Netzwerke regionale Diskurse mitbestimmen und gezielt auf internationale Zielgruppen zugeschnittene Kampagnen verbreiten.

Fallbeispiele: Manipulation in der Praxis

Politische Wahlkampf-Manipulation

Im US-Präsidentschaftswahlkampf 2016 gelangten zahlreiche Fake News und Social Bots in die internationalen Schlagzeilen. Kampagnen, die gezielt auf bestimmte Wählergruppen abzielten, beeinflussten nachweislich Stimmungsbilder und vermutlich auch Wahlergebnisse.

Wirtschaftliche Beeinflussung

Im Bereich des Konsumverhaltens manipulieren Unternehmen systematisch Bewertungen, Rezensionen und Erwähnungen auf Social-Media-Plattformen, um Markenimage oder Produktabsatz zu verbessern. Häufig werden positive Kundenrezensionen gekauft oder fingierte Erfahrungsberichte von bezahlten Nutzern veröffentlicht, die nie tatsächlich ein Produkt genutzt haben. Gleichzeitig versuchen manche Firmen, kritische Meinungen oder negative Bewertungen gezielt zu verdrängen oder zu melden, sodass sie öffentlich weniger sichtbar sind.

Influencer werden außerdem beauftragt, Produkte scheinbar unabhängig zu empfehlen, obwohl es sich um bezahlte Kooperationen handelt – dies ist für Konsumentinnen und Konsumenten oft kaum auf den ersten Blick erkennbar. Durch diese manipulativen Maßnahmen entsteht ein verzerrtes Bild von Qualität und Beliebtheit, das die Kaufentscheidung erheblich beeinflussen kann.

Gesellschaftliche Polarisierung

Gezielte Desinformationskampagnen rund um Pandemie, Migration oder Klimawandel spalten Gemeinschaften und führen zu Misstrauen gegenüber Wissenschaft und Behörden.

| Fallbeispiel | Manipulationsmethode | Auswirkung |

|---|---|---|

| Wahlkampf 2016 (USA) | Social Bots, Fake News | Beeinflussung der öffentlichen Meinung |

| Kryptowährungs-Hypes | Fake-Profile, Hashtags | Blasenbildung, Geldverlust bei Nutzern |

| Pandemie-Fehlinformationen | Emotionalisierung, Fakes | Vertrauenskrise, Gesundheitsrisiken |

Sensibel und wirkungsvoll reagieren: Umgang mit manipulierten Freunden, Familie und Bekannten

In sozialen Netzwerken kann es schnell passieren, dass Freunde, Familienmitglieder oder Bekannte manipulierten Inhalten auf den Leim gehen und diese weiterverbreiten. Die richtige Reaktion erfordert Fingerspitzengefühl, denn offene Konfrontation oder bloße Zurückweisung führt häufig nur zu Abwehr und weiteren Meinungsverhärtungen. Ein sachliches, wertschätzendes Vorgehen erhöht die Chance, konstruktiv aufzuklären und Reflexion anzustoßen.

Empfohlene Schritte:

- Verständnis zeigen und nicht belehren

Auf Vorwürfe oder direkte Kritik verzichten, stattdessen das Gespräch offen und respektvoll suchen. Verständnis für Sorgen oder Unsicherheiten signalisieren. - Nachfragen und Interesse zeigen

Durch behutsames Nachfragen (z. B. „Woher stammt diese Info?“ oder „Was gefällt dir an diesem Beitrag?“) lässt sich oft herausfinden, wie und warum eine bestimmte Meinung übernommen wurde. - Fakten gemeinsam prüfen

Ohne Zwang gemeinsam recherchieren, Informationen vergleichen und seriöse Quellen vorschlagen. Faktenchecks oder wissenschaftliche Artikel anbieten, ohne Druck auszuüben. - Eigene Perspektive schildern

Eigene Gedanken oder Zweifel als subjektive Einschätzung schildern („Ich habe dazu letztens einen interessanten Artikel gelesen…“), anstatt die andere Meinung direkt zu widerlegen. - Dialog aufrechterhalten, nicht abbrechen

Bleibt der Austausch wertschätzend und offen, wird häufiger Reflexion ermöglicht als bei Abwertung oder Kontaktabbruch. Geduld ist gefragt – Meinungsänderungen benötigen Zeit. - Hilfe bei Unsicherheiten anbieten

Unterstützung beim Prüfen von Quellen oder Einschätzen von Nachrichten anbieten und auf Faktencheck-Plattformen verweisen.

Mit einem respektvollen und empathischen Umgang wächst die Chance, dass Zweifel gesät und manipulative Inhalte kritisch hinterfragt werden – ohne soziale Beziehungen unnötig zu belasten.

Ausblick: Wie kann Manipulation nachhaltig eingedämmt werden?

Zukünftig wird es entscheidend sein, Medienkompetenz und Faktenwissen bereits in der Schule zu vermitteln. Die Zusammenarbeit von Politik, Plattformbetreibern und unabhängigen Faktencheckern muss intensiviert werden, um neue Formen der Manipulation frühzeitig zu erkennen. Technische Innovationen wie KI-Detektoren für Deepfakes oder automatische Mustererkennung können dabei unterstützen. Letztlich bleibt die Wachsamkeit und Eigenverantwortung jedes Nutzers ein zentrales Element, um Manipulation und Desinformation zu begegnen.

Fazit: Bewusst gegen Manipulation in sozialen Netzwerken handeln

Manipulation in sozialen Netzwerken ist eine reale und wachsende Gefahr, die gezielt auf Gefühle, Meinungen und das Verhalten der Nutzer abzielt. Dank KI, Bots und professionell orchestrierten Kampagnen geschieht sie oft subtil und bleibt lange unentdeckt. Ein kritischer, kompetenter Umgang mit Informationen – kombiniert mit technischen und gesellschaftlichen Schutzmechanismen – ist das wirksamste Mittel, um der Manipulation entgegenzuwirken und die Integrität digitaler Öffentlichkeit zu bewahren.

FAQ: Häufige Fragen zu Manipulation in Social Media

Was versteht man unter gezielter Manipulation in sozialen Netzwerken?

Gezielte Manipulation beschreibt sämtliche Maßnahmen, die darauf abzielen, Wahrnehmung, Meinungsbildung oder Verhalten von Nutzenden in sozialen Netzwerken bewusst zu beeinflussen – meist durch psychologische Methoden, Desinformation, automatisierte Profile (Bots) oder gezielte Werbeanzeigen.

Wie erkenne ich Manipulation und Desinformation in sozialen Netzwerken?

Warnsignale sind etwa: übermäßige Emotionalisierung, fehlende oder fragwürdige Quellen, viele gleichlautende Kommentare, plötzlich stark ansteigende Reichweite, anonyme oder neue Profile sowie objektiv falsche oder irreführende Aussagen.

Welche Rolle spielen Algorithmen bei der Manipulation?

Algorithmen priorisieren Inhalte, die Engagement erzeugen – besonders polarisierende oder emotionale Themen. Dadurch werden extremere Inhalte häufiger angezeigt, was gezielte Meinungsmache fördert und Filterblasen/Echokammern begünstigt.

Was sind Social Bots und wie wirken sie?

Social Bots sind automatisierte Accounts, die als echte Nutzer auftreten. Sie verbreiten gezielt Inhalte, verstärken Trends, kommentieren oder liken massenhaft und erhöhen so künstlich die Sichtbarkeit bestimmter Meinungen oder Falschinformationen.

Wie funktioniert Microtargeting?

Beim Microtargeting werden anhand persönlicher Nutzungsdaten ganz gezielte Inhalte, Werbeanzeigen oder Botschaften an kleine, spezifische Zielgruppen ausgespielt. So können zum Beispiel politische Aussagen oder Produkte „maßgeschneidert“ zur Beeinflussung eingesetzt werden.

Welche Auswirkungen kann Manipulation auf die Gesellschaft haben?

Folgen sind unter anderem die Verschärfung gesellschaftlicher Spaltung, Verlust von Vertrauen in Medien und Institutionen, Zunahme von Hassrede und Extremismus sowie Beeinflussung von Wahlen und öffentlichen Debatten.

Was ist Astroturfing und wie erkennt man es?

Astroturfing bezeichnet künstlich erzeugte „Basisbewegungen“ oder Zustimmung, meist durch gefälschte Profile, gekaufte Kommentare und Likes. Erkennbar ist es oft an vielen sehr ähnlichen Kommentaren in kurzer Zeit und an anonymen Nutzern.

Wie können sich Nutzende vor Manipulation schützen?

Empfohlen wird: stets kritisch bleiben, Absender und Quellen prüfen, emotionale Inhalte hinterfragen, Bild- und Videomaterial mittels Reverse Search prüfen und verdächtige Inhalte nicht weiterverbreiten.

Was tun, wenn manipulative Inhalte oder Falschmeldungen entdeckt werden?

Diese sollten gemeldet werden (über Plattform-Funktionen), bestenfalls auf seriöse Faktenchecks verweisen und im persönlichen Umfeld auf die Problematik aufmerksam machen – immer sachlich und respektvoll.

Wie reagieren Plattformen und Gesetzgeber auf gezielte Manipulation?

Viele Plattformen kennzeichnen, begrenzen oder löschen manipulierte Inhalte bzw. Falschmeldungen. Gesetzgeber setzen auf mehr Transparenz, Kennzeichnungspflichten etwa für Bots oder Fake-Profile sowie strengere Regulierung im Bereich Wahlkampf, Werbung und Datenschutz.