Deepfake-Videos sorgen immer häufiger für Verunsicherung: Mit Hilfe künstlicher Intelligenz lassen sich täuschend echte Fälschungen erstellen, bei denen selbst geschulte Augen Schwierigkeiten haben, Wahrheit von Manipulation zu unterscheiden. Doch wie kann man sich im digitalen Alltag vor gefälschten Videos schützen? In diesem Artikel zeigen wir, woran man Deepfakes erkennt und welche einfachen Methoden dabei helfen, Fake-Videos schnell und sicher zu entlarven.

Deepfake – Das Phänomen erklärt

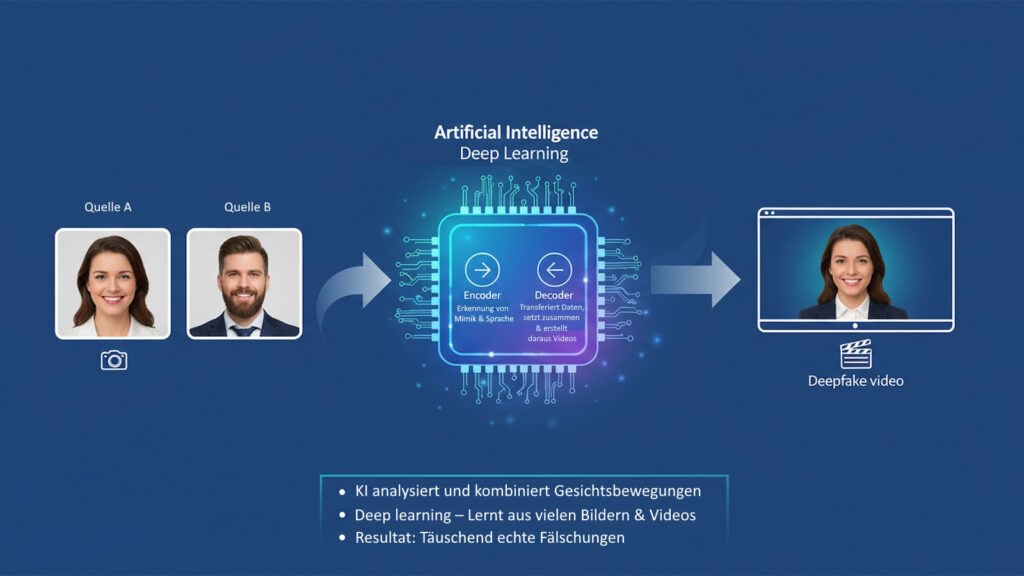

Der Begriff Deepfake steht für die Verbindung von Deep Learning (tiefes maschinelles Lernen) und Fake (Fälschung). Die innovative Technologie ermöglicht die digitale Erstellung oder Manipulation von Medieninhalten, insbesondere von Videos, sodass diese täuschend echt wirken. Mittels Künstlicher Intelligenz entstehen so beispielsweise gefälschte Videos, in denen Personen Dinge sagen oder tun, die sie nie getan haben.

Synthetisch erzeugte Videoinhalte sind mehr als ein technisches Kuriosum. Die Fähigkeit, authentisch wirkende Fake-Videos – insbesondere durch Deep Learning – zu erstellen, verändert die Medienlandschaft und Kommunikation weltweit. Die Möglichkeiten, aber auch die Gefahren, reichen von unterhaltsamen Parodien bis hin zu gezielter Desinformation.

Die Technik hinter dem Deepfake

Manipulierte, synthetisch erzeugte Videoinhalte beruhen auf Künstlicher Intelligenz (KI), insbesondere auf sogenannten Generative Adversarial Networks (GANs). Zwei künstliche neuronale Netzwerke – ein Generator und ein Diskriminator – treten gegeneinander an: Das eine erzeugt künstliche Inhalte (z.B. Fake-Videos), das andere prüft deren Echtheit. Ziel ist es, Videos, Bilder oder Audiodateien so zu manipulieren, dass der Betrachter sie nicht mehr als Fälschung erkennt.

Typische Schritte der Deepfake-Erstellung

- Datenbeschaffung: Sammlung großer Mengen an Bild- und Videomaterial der Zielperson.

- Modelltraining: Das KI-Modell lernt Gesichtszüge und Bewegungsabläufe anhand des Materials.

- Generierung: Das Gesicht oder die Stimme wird digital in ein bestehendes Video integriert.

- Nachbearbeitung: Verfeinerung von Details wie Lichteffekten, Mimik oder Lippenbewegungen.

Allgemeine Merkmale von synthetisch erzeugten Videoinhalten

- Sehr hohe Bild- und Tonqualität

- Mimik, Lippenbewegungen und Sprache passen meist exakt zusammen

- Oft erst bei genauer Betrachtung als Fälschung zu erkennen

Tabelle: KI-Technologien hinter Deepfake-Systemen

| Technologie | Funktion |

|---|---|

| Generative Adversarial Network (GAN) | Erzeugung realistischer Bilder/Videos |

| Autoencoder | Reduktion und Rekonstruktion von Daten |

| Face-Swapping | Austausch von Gesichtern in Videos |

| Voice Cloning | Digitale Nachbildung menschlicher Stimmen |

Geschichte und Entwicklung der Deepfake-Technologie

Die Entstehung der Deepfake-Technologie ist eng mit dem Fortschritt im Bereich Künstliche Intelligenz verknüpft. Erste Face-Swapping-Ansätze gab es bereits in den frühen 2010er Jahren. Bekannt wurden synthetisch erzeugte Videoinhalte ab etwa 2017, als Tools und Software erstmals öffentlich verfügbar waren.

Meilensteine der Entwicklung

- 2014: Einführung von GANs, die den Grundstein für viele Technologien legen

- 2017: Verbreitung der ersten manipulierten Videos – insbesondere im Kontext von Prominenz, Politik und Social Media

- Seit 2020: Professionalisierung – Fake-Videos sind kaum noch von echten Inhalten zu unterscheiden

Liste: Bekannteste Deepfakes in der Öffentlichkeit

- Gefälschte Reden von Politikern (z. B. Obama, Merkel): Die Technologie wurde verwendet, um berühmte Politiker wie Barack Obama oder Angela Merkel scheinbar Dinge sagen zu lassen, die sie nie gesagt haben. Ziel war es teilweise, die Gefahren dieser Technologie aufzuzeigen – aber auch um gezielt zu manipulieren oder Falschinformationen zu verbreiten. Solche Videos können das Vertrauen in seriöse Nachrichtenquellen und die Politik stark beeinträchtigen.

- Deep Fake von Tom Cruise auf TikTok: 2021 tauchten auf TikTok mehrere gefälschte Videos des Channels „@deeptomcruise“ auf. Sie zeigten „Tom Cruise“, wie er u. a. Golf spielt oder Witze erzählt – und wirkten extrem echt. Millionen Zuschauer konnten die Videos zunächst kaum von echten Clips unterscheiden. Dies löste eine breite Diskussion über die Möglichkeiten und Risiken von manipulierten Videoinhalten im Bereich Social Media aus.

- Parodien und Satiren in TV-Sendungen & YouTube: Formate wie „Auf Streife – Die Sat.1-Polizeishow“ oder die US-Show „Saturday Night Live“ nutzen manipulierte Videos, um Prominente oder Politiker satirisch zu imitieren. Während der Humor im Vordergrund steht, zeigen diese Beispiele, wie verfügbar und leistungsfähig die Technik schon für Entertainment geworden ist.

- Deepfake von Mark Zuckerberg: 2019 wurde ein manipuliertes Video veröffentlicht, in dem Meta/Facebook-Chef Mark Zuckerberg angeblich offen über Macht und Kontrolle spricht. Das Video hatte den Zweck, auf die Gefährlichkeit der Technologie hinzuweisen und zu testen, wie Plattformen wie Instagram auf derartige Manipulationen reagieren.

- Fake-Weihnachtsansprache der Queen: Der britische Sender Channel 4 produzierte 2020 eine gefälschte Weihnachtsbotschaft von „Queen Elizabeth II.“, in der sie ungewöhnliche Dinge sagte und tanzte. Ziel war hier, für kritische Medienkompetenz bezüglich Fake-Videos zu sensibilisieren.

- Deepfake von Elon Musk in Krypto-Betrugsmasche: Betrüger nutzten gefälschte Videos von Elon Musk, in denen er scheinbar für Krypto-Investitionen warb. Viele Menschen wurden dadurch getäuscht und verloren Geld an dubiose Anbieter.

- Falsches Selenskyj-Video: Nach dem Beginn des russischen Angriffs auf die Ukraine veröffentlichte eine pro-russische Gruppe eine Video-Manipulation mit Präsident Selenskyj, der zur Kapitulation auffordert. Das Video wurde schnell als Fälschung entlarvt, zeigte aber, wie solche Fakes im Kontext von Kriegspropaganda genutzt werden können.

- Bruce Willis & Werbung: Für Werbung in Russland wurde das Gesicht von Bruce Willis digital genutzt. Zwar hatte Willis seine Bildrechte für diese Zwecke nicht persönlich freigegeben, jedoch erlaubte eine Agentur unter bestimmten Bedingungen den Einsatz. Die Kampagne löste eine Debatte über Bildrechte und ethische Fragen bei manipulierten oder synthetisch erzeugten Videoinhalten aus.

Auswirkungen von Deepfakes in der Öffentlichkeit

- Vertrauensverlust: Gefälschte Video-Inhalte können das Vertrauen in Medien und öffentliche Institutionen schwächen, da es schwieriger wird, echte von gefälschten Videos zu unterscheiden.

- Desinformation & Manipulation: Sie werden gezielt genutzt, um Falschinformationen zu verbreiten (z. B. im Wahlkampf, Kriegspropaganda).

- Gefahren für Persönlichkeitsrechte: Prominente und Privatpersonen können ohne ihre Zustimmung digital nachgeahmt werden.

- Wachsende Bedeutung der Medienkompetenz: Es wird immer wichtiger, dass Menschen Inhalte kritisch hinterfragen und seriöse Quellen prüfen.

- Technologieeinsatz für Erkennung: Es entstehen immer mehr Tools, die Deepfakes eindeutig als solche identifizieren sollen.

Deepfake im Alltag: Anwendungen und Impact

Die Technologie hat bereits vielfältige Bereiche des täglichen Lebens beeinflusst. Fake-Videos und -Audios werden verwendet, um täuschend echte Werbespots, Filme oder Social-Media-Posts zu generieren.

Anwendungsfelder

- Unterhaltung & Film: Nachsynchronisation, digitales Altern/Verjüngen, Parodien.

- Werbung: maßgeschneiderte Werbevideos mit prominenten Avataren.

- Gaming: Erzeugung realistischer Spielfiguren und Dialoge.

- Betrug & Erpressung: Fake-Videos als Mittel zur Täuschung und Manipulation.

Tabelle: Deepfake-Einsatz nach Branche

| Einsatzbereich | Beschreibung |

|---|---|

| Filmindustrie | digitale Anpassungen von Schauspielern |

| Werbung | Personalisierte Spots mit KI-Avataren |

| Social Media | Gefälschte Videos, Parodien, Memes |

| Politik | Manipulierte Reden für Desinformation |

| Cyberkriminalität | Betrugsversuche durch gefälschte Identitäten |

Deepfake erkennen: Methoden und Tools

Das Fälschungen erkennen ist eine stetig wachsende Herausforderung, da die Fake-Videos immer realistischer wirken. Unterschiedliche Tools und Verfahren helfen bei der Identifikation gefälschter Medien.

Technische Prüfungsmöglichkeiten

- Bildanalyse: Untersuchung von Blinzelfrequenz und Augenbewegungen, da verschiedene Modelle Gesichtszüge manchmal ungenau generieren.

- Tonanalyse: Asynchrone Audio- und Lippenbewegungen können auffällig sein.

- Metadaten-Überprüfung: Analyse der Datei auf Bearbeitungs- und Bearbeitungsspuren.

- KI-Detektor: Automatisierte Tools prüfen auf typische Artefakte und Muster.

Tabelle: Tools zum Deep Fake Videos erkennen

| Tool/Begriff | Funktion |

|---|---|

| Deepware Scanner | Prüft Videos gezielt auf synthetische Elemente |

| Microsoft Video Authenticator | Echtzeit-Erkennung von Fakes |

| Sensity AI | Analyse und Kennzeichnung von Fake-Videos |

| Reality Defender | KI-basierte Klassifizierung von Medien |

| Deepware Deepfake Detector | Scannt und erkennt Fakevideos |

Gefahren für Gesellschaft, Politik, Wirtschaft

Fake-Videos stellen eine ernstzunehmende Gefahr für Gesellschaft, Politik und Wirtschaft dar. Sie können gezielt eingesetzt werden, um Meinungen zu manipulieren oder Betrug zu begehen.

Typische Bedrohungsszenarien

- Desinformation: Verbreitung gefälschter Nachrichten oder Statements durch Fake-Videos.

- Erpressung: Gefälschte kompromittierende Inhalte.

- Identitätsdiebstahl: Missbrauch von Gesichtern und Stimmen für Social Engineering.

- Finanzbetrug: Fake-Audios von Vorstandschefs zur Veranlassung von Überweisungen.

Liste: Auswirkungen von Deepfake-Betrug

Rufschädigung prominenter Personen

Verfälschte Video-Clips können dazu genutzt werden, Prominente oder öffentliche Personen in kompromittierenden oder peinlichen Situationen darzustellen, obwohl diese Ereignisse nie stattgefunden haben. Solche gefälschten Videos oder Audios werden oft schnell über soziale Netzwerke verbreitet, sodass der Eindruck entstehen kann, die Inhalte seien echt. Das schadet dem Ruf und der Glaubwürdigkeit der betroffenen Personen erheblich und kann private wie berufliche Konsequenzen haben.

Manipulation von Wahlen und Abstimmungen

KI-Video-Fälschungen werden eingesetzt, um die öffentliche Meinung gezielt zu beeinflussen. Falsch zugeschriebene Aussagen oder Handlungen von Politikerinnen und Politikern können bei der Bevölkerung Misstrauen oder Hass schüren. Dadurch besteht die Gefahr, dass Wähler in ihrer Meinungsbildung getäuscht werden – mit möglicherweise weitreichenden Folgen für den Ausgang von Wahlen oder Referenden. Auch das Vertrauen in demokratische Prozesse wird dadurch untergraben.

Angriffe auf Unternehmen durch CEO-Fraud

Im sogenannten „CEO-Fraud“ verwenden Kriminelle die Technologie, um Geschäftsführer, Vorstände oder andere Führungskräfte täuschend echt in Videos oder Audionachrichten nachzuahmen. Mitarbeitende werden dann beispielsweise angewiesen, hohe Geldbeträge auf bestimmte Konten zu überweisen oder vertrauliche Informationen herauszugeben. Diese Form des Betrugs ist besonders gefährlich, da sie gezielt auf die interne Kommunikation von Unternehmen abzielt und großen finanziellen Schaden verursachen kann.

Deepfake und Medien: Fake-Videos zwischen Skandal und Unterhaltung

Medien sind Hauptverbreitungskanal für gefälschte AI-Videos. Während im Entertainment häufig mit Deepfake-Technologie gespielt wird, können die gleichen Methoden gezielt Skandale und Desinformation auslösen.

Chancen im Entertainment

Die Technologie bietet zahlreiche innovative Möglichkeiten im Bereich Parodien und Comedy. Durch den täuschend echten Austausch von Gesichtern lassen sich bekannte Persönlichkeiten in neue, oft humorvolle Kontexte setzen. Dies eröffnet Comedians und Kreativen ganz neue Spielräume, etwa um Parodien, satirische Clips oder virale Sketche zu produzieren, die das Publikum unterhalten und zugleich gesellschaftliche Themen pointiert ansprechen.

Ein weiteres Anwendungsfeld ist die Rekonstruktion verstorbener Schauspieler für neue Produktionen. Mithilfe hochwertiger AI-Clips kann das Aussehen und die Mimik bereits verstorbener Darsteller digital wiederhergestellt und in neue Filmaufnahmen integriert werden. Diese Technik wird beispielsweise genutzt, um ikonische Figuren weiterleben zu lassen oder offene Erzählstränge zu schließen, sofern rechtliche und ethische Fragen geklärt sind.

Auch das Enhanced Storytelling im Film profitiert von der Technologie. Regisseurinnen und Regisseure können Charaktere wesentlich flexibler gestalten, alternative oder historische Versionen von Figuren zeigen oder Schauspieler virtuell altern und verjüngen lassen. Dadurch entstehen kreative Möglichkeiten für überraschende Wendungen, Rückblicke und visuelle Erzähltechniken, die das Filmerlebnis deutlich bereichern.

Risiken im Journalismus

Im Journalismus bergen Deepfakes erhebliche Risiken. Gefälschte Interviews oder Pressekonferenzen können dazu führen, dass Falschinformationen verbreitet werden und Medieninhalte ihre Glaubwürdigkeit verlieren. Gleichzeitig entsteht eine große Verunsicherung, da für das Publikum echte und manipulierte Bewegtbilder immer schwerer voneinander zu unterscheiden sind. Das macht es für Medienschaffende zunehmend schwieriger, authentische von gefälschten Inhalten abzugrenzen.

Die journalistische Integrität gerät dadurch unter Druck, da Faktenchecks aufwendiger, zeitintensiver und technisch anspruchsvoller werden. Redaktionen müssen zusätzliche Ressourcen aufwenden, um die Echtheit von Bild- und Videomaterial zu überprüfen und somit verantwortungsvolle Berichterstattung zu gewährleisten.

Rechtliche Aspekte rund um Deepfakes

Die Gesetzeslage zu Deepfakes ist international unterschiedlich. Oft bewegen sich die Ersteller und Verbreiter von gefälschten Videos in einer rechtlichen Grauzone.

Rechtliche Schlüsselfragen

- Persönlichkeitsrechte: Unrechtmäßige Nutzung von Bild und Stimme.

- Urheberrecht: Verletzung geistigen Eigentums.

- Strafrecht: Betrug, Erpressung, Identitätsdiebstahl durch Fake-Videos.

- Datenschutz: Verwendung persönlicher Daten zum Training von KI-Modellen.

Tabelle: Rechtliche Risiken bei Deepfakes

| Gebiet | Risiko | Mögliche Folgen |

|---|---|---|

| Persönlichkeitsrecht | Verletzung der Privatsphäre | Schadensersatz, Abmahnung |

| Urheberrecht | Nutzung urheberrechtlich geschützter Werke | Unterlassung, Schadensersatz |

| Strafrecht | Täuschungsabsicht, Betrug | Geldstrafe, Freiheitsstrafe |

| Datenschutz | Legale und illegale Nutzung von Daten | Bußgelder, Klagen |

Deepfake als Werkzeug für Kreativität und Innovation

Neben den Risiken birgt die Deepfake-Technologie großes Innovationspotenzial, insbesondere in der Kreativwirtschaft.

Positive Einsatzmöglichkeiten von Deep-Fake

- Film und Fernsehen: Altersunabhängige Rollenbesetzung, virtuelle Sets und Szenen.

- Bildung: Historische Reden und Präsentationen nachbauen.

- Barrierefreiheit: Anpassen von Inhalten für Blinde oder Gehörlose durch KI-generierte Sprecher/Untertitel.

- Personalisierte Werbung: Zielgruppenspezifische Clips und gezielte Ansprache.

Positive Anwendungsbeispiele in der Umsetzung

- Virtuelle Museumsführer mit historischen Persönlichkeiten ermöglichen es, Besucherinnen und Besuchern Ausstellungen auf völlig neue Weise zu erleben. Mithilfe von Deepfake-Technologie werden bekannte Figuren aus der Geschichte „zum Leben erweckt“ und führen durch die Ausstellung, erklären Exponate oder beantworten Fragen. Dies macht den Museumsbesuch lebendiger und fördert das Interesse an Geschichte.

- Die Synchronisation von Vortragsvideos in viele Sprachen wird durch KI deutlich vereinfacht, da Rednerinnen und Redner digital synchronisiert werden können, sodass Lippenbewegungen und Mimik zur Tonspur in der jeweiligen Zielsprache passen. Inhalte werden so weltweit verständlicher und barrierefreier zugänglich gemacht, ohne an Authentizität einzubüßen.

- KI-Avatare für personalisiertes E-Learning sorgen dafür, dass Lehrinhalte individuell auf Lernende zugeschnitten werden können. Lernplattformen nutzen intelligente Avatare, die nicht nur Inhalte anschaulich erklären, sondern auch direktes Feedback geben und sich auf die Bedürfnisse der einzelnen Nutzerinnen und Nutzer einstellen.

- Ergänzend dazu finden KI-generierte Moderationen bei Livestreams oder Veranstaltungen Anwendung. Diese Avatare präsentieren in Echtzeit Informationen, leiten durch das Programm und können flexibel auf Situationsänderungen reagieren.

- Nicht zuletzt werden KI-gestützte Charakteranimationen in Computerspielen immer realistischer, sodass Computerspielfiguren glaubwürdige Mimik, Sprache und Interaktionen zeigen und dadurch immersivere Spielerlebnisse ermöglichen.

Deepfake in der Forschung: Aktuelle Studien und Trends

Die Deepfake-Forschung ist ein dynamisches Feld. Weltweit arbeiten Universitäten, Unternehmen und Sicherheitsbehörden an neuen Methoden zur Erstellung und Erkennung von Fake-Videos.

Wichtige Forschungsrichtungen

- Verbesserung der Deepfake-Erkennung durch KI-Modelle

- Automatisierte “Forensic” Algorithmen zur Analyse digitaler Inhalte

- Ethik der KI-generierten Inhalte

- Aufklärungskampagnen zu den Risiken und Erkennungsmerkmalen von Deepfakes

Tabelle: Forschungsprojekte zu Deepfake-Technologien

| Projekt / Institution | Schwerpunkte |

|---|---|

| FaceForensics++ | Internationale Benchmark-Datenbank (siehe auch hier) |

| MIT Media Lab | Deepfake Detection, Aufklärung |

| German Research Center for Artificial Intelligence | Echtzeiterkennung |

| Google/DeepMind | Gegenmaßnahmen durch KI-Training |

Schutz vor Deepfakes: Tipps und Präventionsmaßnahmen

Auch ohne technische Hilfsmittel gibt es Wege, Deepfakes und Fake-Videos zu erkennen und sich vor ihnen zu schützen.

Checkliste zum Deepfake erkennen

- Ungewöhnliche oder starre Mimik beachten

- Unsicherheiten der Lippensynchronität analysieren

- Wiederkehrende Artefakte, Flackern oder unscharfe Ränder erkennen

- Anhaltende Gleichförmigkeit der Gesichtsausdrücke überprüfen

- Quellen rückverfolgen – stammt das Video aus einer vertrauenswürdigen Quelle?

- Online-Tools und Detektoren zur Prüfung nutzen

Technische Details und Herausforderungen

Technisch ist das Deepfake erkennen ein “Arms Race” zwischen Fälschern und Erkennern von Fake-Videos. Es gibt fortgeschrittene Bild- und Tonanalyseverfahren.

Herausforderungen

- Ständige Weiterentwicklung der Deepfake-Algorithmen

- Verbesserte Gesichtsanimation und -synchronisation

- Professionelle Bearbeitung macht Fake-Videos fast nicht unterscheidbar

- Fehlende Metadaten durch mehrfaches Teilen in sozialen Netzwerken

Innovative Erkennungsmethoden

- Nutzung von Blockchain zur unveränderlichen Markierung echter Videos

- Einbettung von Wasserzeichen durch Kamera-Hardware

- Analyse typischer Bildfehler wie fehlerhafte Ohren, unnatürliche Schatten

Technische Prävention für Unternehmen und Behörden

- Einsatz von Deepfake-Erkennungssoftware

- Schulung von Mitarbeitern im Umgang mit Social Engineering

- Zwei-Faktor-Authentifizierung für wichtige Prozesse

Deepfake-Generatoren: Tools und Plattformen im Überblick

Trotz der Risiken gibt es eine große Zahl an Deepfake-Generatoren, viele davon sind kostenlos nutzbar oder als Open-Source-Software verfügbar.

Tabelle: Bekannte Deepfake-Generatoren

| Tool / Plattform | Funktionen | Zugänglichkeit |

|---|---|---|

| DeepFaceLab | Komplexe Deepfake-Videoproduktion | Open Source |

| Zao | Handy-App zum Gesichtertausch | kostenfrei |

| Reface App | Schnelles Erstellen von Fake-Videos | kostenlos |

| FaceSwap | Für Desktop und Mobile, viele Tutorials | kostenlos |

| MyHeritage Deep Nostalgia | Verwandlung alter Fotos in Animationen | kostenlos |

| Synthesia.io | Professionelle KI-Avatare für Business | kostenpflichtig |

Deepfake in Zahlen: Statistiken und Marktentwicklung

Innerhalb kurzer Zeit ist die Anzahl der gefälschten Videos im Internet exponentiell gestiegen. Möglich wird dies vor allem durch frei verfügbare KI-Tools und anwenderfreundliche Software, mit denen auch technisch weniger versierte Personen täuschend echte Videos oder Audiodateien erstellen können. Gleichzeitig wächst das Angebot an Deepfake-Inhalten rasant, da sie in sozialen Netzwerken, auf Videoplattformen und Messenger-Diensten leicht geteilt werden können. Diese Entwicklung macht es zunehmend schwieriger, zwischen authentischen und manipulierten Inhalten zu unterscheiden, und stellt sowohl Privatpersonen als auch Institutionen vor neue Herausforderungen im Umgang mit digitalen Medien.

Deepfake-Zahlen und Trends

| Jahr | Geschätzte Anzahl gefälschter Videos weltweit | Anteil betrügerisch genutzter Inhalte |

|---|---|---|

| 2018 | 8.000 | ca. 90% (davon viele Inhalten zu Promis oder Politik) |

| 2020 | 100.000 | ca. 85% |

| 2022 | 250.000+ | ca. 80% – Trend steigend |

| 2024 | über 500.000 | weiter zunehmend |

Marktprognose

Branchenexperten prognostizieren eine weitere starke Zunahme von Fakevideos und gefälschten Medien auch in seriösen Geschäftsanwendungen. Besonders Unternehmen aus den Bereichen Marketing, Schulung und Kundenservice setzen vermehrt KI-generierte Avatare und synthetische Medien ein, um Prozesse zu automatisieren und neue, innovative Nutzererfahrungen zu schaffen. Gleichzeitig wächst jedoch die Sorge, dass diese Technologien auch für Betrugsversuche, Identitätsdiebstahl und gezielte Manipulation missbraucht werden könnten.

Zukünftige Entwicklungen bei gefälschten Inhalten

Die Fälschungs-Technologie entwickelt sich rasant weiter. Die Zukunft wird geprägt sein von noch realistischeren gefälschten Videos, aber auch von zunehmend besseren Detektionssystemen.

Trends der nächsten Jahre

- Echtzeit-Fake Inhalte für Live-Streams und Videochats

- KI-basierte Schutzsysteme direkt auf Social-Media-Plattformen

- Integration von Echtheitsnachweisen in Kameras und Smartphones

- Stärkere Regulierung und internationale Gesetze

- Öffentliche Debatte zu Transparenz und Ethik digitaler Inhalte

Liste: Wichtige Faktoren für die Zukunft

- Kooperationen zwischen Regierungen, Techfirmen und Gesellschaft

- Ausbau von Präventions- und Aufklärungsmaßnahmen

- Förderung von Medienkompetenz in Schulen und Erwachsenenbildung

Fazit: Chancen, Risiken und der Umgang mit KI-basierten Fälschungen

Die Technologie für gefälschte Videos ist längst fester Bestandteil der digitalen Welt. Sie bietet enorme Chancen für Kreativität, Unterhaltung und Innovation, birgt zugleich aber erhebliche Risiken für den Einzelnen und die Gesellschaft. Fake Videos und KI-basierte Fälschungen werden weiter zunehmen und sowohl die Sicherheit als auch das Vertrauen in digitale Inhalte herausfordern.

Achtsamkeit, technische Gegenmaßnahmen und rechtliche Regelungen sind entscheidend, um die Vorteile von KI-Inhalten nutzen und Missbrauch verhindern zu können. Nur so bleibt die Balance zwischen Fortschritt, Innovation und digitaler Sicherheit gewahrt.

FAQ: Die häufigsten Fragen zu Deepfake und Video-Fälschungen

-

Was ist ein Deepfake?

Dabei handelt es sich um ein digitales Medium – meist ein Video, seltener ein Audio oder Bild –, das mithilfe künstlicher Intelligenz (insbesondere Deep Learning) so bearbeitet oder generiert wurde, dass es täuschend echt erscheint, obwohl es manipuliert oder komplett erfunden wurde. Typische Video Fälschungen zeigen Personen, die etwas sagen oder tun, ohne es je tatsächlich getan zu haben.

-

Wie erkennt man einen gefälschten Video-Inhalt?

Typische Erkennungsmerkmale sind unnatürliche Gesichtszüge, unscharfe Bildränder, fehlerhafte Lippensynchronität und unstimmige Augenbewegungen. Unterstützung bieten Detector-Tools.

-

Sind gefälschte Video-Inhalte illegal?

Die Verwendung der Technologie ist nicht verboten. Illegal wird ein derartiger Fake, wenn damit Schaden angerichtet wird: z. B. bei Identitätsdiebstahl, Erpressung, Diffamierung oder Betrugsversuch. Auch das ungenehmigte Verwenden fremder Gesichter oder Stimmen kann Persönlichkeitsrechte und Datenschutzgesetze verletzen.

-

Welche Tools gibt es zum Erstellen von Deepfakes?

Bekannte Werkzeuge sind DeepFaceLab, Reface App, Zao und Synthesia.io.

-

Wie kann man sich vor Video Fälschungen schützen?

Auf vertrauenswürdige Quellen achten, Fake-Video-Detektoren nutzen und Medienkompetenz fördern.

-

Wie funktioniert die Technologie für gefälschte Medieninhalte?

Verfälschte Videos basieren in der Regel auf sogenannten Generative Adversarial Networks (GANs). Diese benutzen große Datenmengen von Gesichtern, Stimmen oder Bewegungen und erzeugen daraus realistische Fakes. Ein Generator erstellt Fälschungen, ein Diskriminator bewertet deren Echtheit. Je mehr sie miteinander “trainieren”, desto perfekter wird das Fake-Video.

-

Woran erkennt man ein unrealistisches, gefälschtes Video?

Fake-Aufnahmen sind oft erst bei genauer Analyse zu enttarnen. Typische Hinweise:

– Unnatürliche oder steife Gesichtsausdrücke

– Ruckelnde oder asynchrone Lippenbewegungen

– Seltsam flackernde oder unscharfe Bildbereiche

– Unstimmige Lichtverhältnisse oder Reflexionen

– Fehlender Blinzelrhythmus

– Spezielle Tools (z. B. Deepware Scanner, Reality Defender) helfen, gefälschte Videoclips automatisch zu erkennen. -

Welche Gefahren gehen von Fake AI-Videos aus?

Hauptgefahren sind:

– Desinformation & gezielte Fake-News

– Rufschädigung und Mobbing

– Betrug durch gefälschte Identitäten

– Erpressung mit Fake-Video-Inhalten

Zudem steigen die Herausforderungen für Medien und Behörden, Manipulation effizient und schnell zu entlarven. -

Wer nutzt diese innovative Technologie?

Sowohl Kriminelle als auch Filmstudios, die Kreativbranche oder Technologieunternehmen nutzen AI-erstellte Videos. In der Forschung dienen sie zur Entwicklung neuer Bild- und Sprachtechnologien, während sie in der Unterhaltungsbranche neue künstlerische Möglichkeiten eröffnen. Gleichzeitig gibt es einen Graubereich, da gefälsche Videos auch für Cyberkriminalität eingesetzt werden.

-

Gibt es legale und sinnvolle Verwendungen von KI-erstellten Videos und Inhalten?

Ja, beispielsweise:

– Rekonstruktion verlorener Filmszenen

– Synchronsprache für Mehrsprachigkeit in Filmen

– Barrierefreiheit durch Anpassung von Inhalten

– Bildung und Wissenschaft (z. B. „wiederbelebte“ Reden historischer Persönlichkeiten) -

Wie kann man sich vor Fake-Video Betrug schützen?

1. Immer Inhalte aus seriösen Quellen konsumieren

2. Einen gesunden Skeptizismus bei viralen Videos und News zeigen

3. Bei Verdacht spezialisierte Fake-Checker verwenden

4. Auf typische Unstimmigkeiten (siehe oben) achten

5. Unternehmen und Behörden sollten Mitarbeitende schulen und KI-gestützte Detektionssysteme einsetzen -

Ist die Verwendung eines Deepfake immer erkennbar?

Nein, neueste Versionen sind für das menschliche Auge kaum noch zu entlarven. Die Mitentwicklung technischer Prüfungswerkzeuge ist daher entscheidend, um Fälschungen erkennen zu können.

-

Dürfen Medien und Journalisten Deepfakes einsetzen?

Journalisten sind verpflichtet, bei der Nutzung transparent zu sein und für eine eindeutige Kennzeichnung zu sorgen. Nicht gekennzeichnete Inhalte können das Vertrauen in Medien nachhaltig schädigen und könnten rechtliche Schritte nach sich ziehen.

-

Was bedeuten Begriffe wie Fake-Video, Face Swap oder Voice Cloning im Deepfake-Kontext?

Fake-Video: Sammelbegriff für manipulierte oder synthetisch erzeugte Videoinhalte

Face Swap: Austausch von Gesichtern/Identitäten in einem Video mithilfe KI

Voice Cloning: Digitalisierung und Imitation einer Stimme durch Deep Learning

Alle diese Technologien sind Varianten oder Bestandteile des Deepfake-Phänomens.